この記事の要点は...

- AIのモデルは、人間にも理解することができない!?

- 機械学習するAIの背景に潜む、大きな3つの問題

- AIシステムの品質を保証するための、東芝のガイドラインとは?

AIという言葉が定着して久しい。テクノロジーの進歩はもはや不可逆的な流れであり、社会構造が変わる前提で私たちの生活を考える必要がある。しかし、社会におけるAIシステムのあり方や、その工学的なアプローチに関する議論は始まったばかりだ。特に、「AIシステムの品質保証」と呼ばれる分野は世界で模索中であり、アップデートを続けている。

たとえば「人間の顔を識別するためのAIが、ある人を誤って動物と判定してしまった」など、目指す品質をAIがきちんと果たせるのかが問われている。そのような中、東芝は50年以上のAI研究開発を続けている先進企業として、この課題に力を入れている。AIシステムの品質保証プロジェクトに携わる、東芝 ソフトウェア技術センターの久連石氏に話を聞いた。

今、話題になっているAIとはどういうものか?

AIと言っても色々な種類があるが、今回対象とするのは、機械学習を活用したAIだ。機械学習とは、膨大な量のデータをAIが自動学習し、データに潜むパターンを抽出して、特定のモデルを構築する仕組みである。機械学習の話題の手法が、いわゆる「深層学習(ディープラーニング)」だ。

さて、本題に入る前にAIの歴史を少しおさらいしよう。遡ること約半世紀。第1次AIブームが起き、現在は第3次ブームである。ただし、今回は単なるブームでは終わらない。ここまでAIに注目が集まるようになった大きなきっかけは、2015年にGoogleが開発したAlphaGoが、人間のプロ囲碁棋士に勝利したことにある。ここで、久連石氏の言葉を紹介する。

株式会社東芝 ソフトウェア技術センター ソフトウェアエンジニアリング技術部 エキスパート 久連石 圭氏

「その前にもIBMのディープブルーが、チェスの世界チャンピオンを破っています。けれどもチェスと囲碁では複雑さの次元がまったく異なるため、囲碁でAIが人に勝つのは無理だろうと考えられていました。

なぜAlphaGoは、人間に勝てたのか。それは、膨大な対局データを元に、数1,000万回も繰り返して自動的に学習したからです。この次元に達してしまうと、その開発者たちでさえ、AIの思考パターンを捉えるのは難しいでしょう」

人間によって開発されたにもかかわらず、いつの間にか人間には理解できないレベルに到達している。これが今のAIの実態だ。

開発した人間にも、AIのモデルは理解できない

前述の通り、深層学習をする際、インプットするデータに対して、どのようにしてアウトプットを生んでいるのか人間にも予想ができない。このようなAIを社会インフラなどの重要なシステムに組み込むことを考えると、「本当に意図した通りに動作するかが分からない」となる。したがって、どうすればAIシステムを安心して使えるかがポイントになる。この課題を「AIシステムの品質保証」と呼び、世界中でAIの社会実装を試みる開発者たちが議論を行っており、東芝も同様だ。

「東芝には、AIの品質保証を議論する『AI品質保証プロジェクト』があります。AIを搭載したシステムの開発において、その品質をどのように担保するのかを以前より話し合っていました。社外からも品質保証に関する問い合わせが増えてきたこともあり、2019年にガイドライン策定に向けたAIの品質保証プロジェクトが発足したのです」

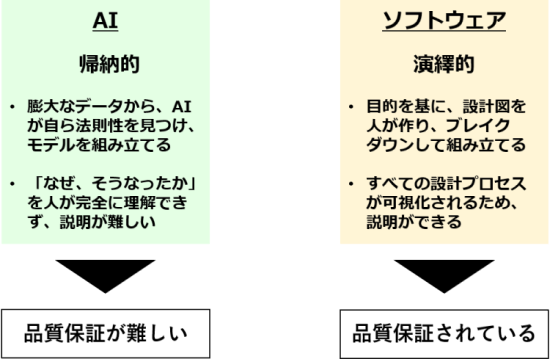

久連石氏は、ソフトウェアエンジニアリングの技術者だ。AIの専門家ではない彼が、なぜこのようなプロジェクトを担うことになったのか。ここにはAI独自の問題が絡んでいるという。例えば、ソフトウェアは設計図ありきで開発され、演繹的手法に基づく。一方で、ディープラーニングを含むAIの機械学習は、帰納的である。

人が最初に設計図を作り、そこに定められた目的を達成するために何をすればよいかをブレイクダウンして組み立てていく演繹的手法。こうしたプロセスはすべて可視化されるため、説明ができる。つまり、ソフトウェアの品質は保証されているといえる。一方で、膨大なデータからAIが自ら法則性を見つけ出し、それに基づいてモデルが組み立てられる帰納的手法は、「なぜ、そうなったのか」ということが人が完全には理解できない。要するに説明できないので、どんなアウトプットが出てくるか予測できず、品質の保証がしにくいということだ。この根本的な違いを実感として捉えられていることが、AIの品質保証を考える上で非常に重要なのだ。それもあって、AIを活用したいシステム・ソフトウエア技術者から品質評価について相談を受けるうちに、久連石氏はプロジェクトに深く関わるようになった。

納的なAIと、演繹的なソフトウェアの品質の考え方

「たとえば、猫の画像を認識するAIがあるとします。このようなAIは、膨大な猫の画像から共通要素を抽出します。その結果、猫と犬の画像を見せると、どちらが猫であるかを瞬時に正確に判断できるようになるのです。ただし、それらの画像からAIが猫に共通する特徴として、一体何を、どのように抽出したのか。この判断の過程を人は理解できないのです」

AIの品質保証が複雑になる3つの要因とは?

AIの品質保証を考える時、3つの問題を理解することが重要だという。1つ目は、ブラックボックス問題。2つ目は、バイアス問題。そして3つ目が、セキュリティ問題である。

1つ目のブラックボックス問題は、上述の帰納的手法の箇所で述べたように、AIの学習アルゴリズムがどのように動いているのか、プロセスを明らかにできない問題だ。これについて、久連石氏は苦渋を滲ませこう話す。

「まさに今、私たちの考えているテーマがそこです。開発したAIモデルが、それで本当に完璧なのか。そのモデルを、そのまま社会に提供して大丈夫なのかということを考えなければなりません。それに対し、精度を高めて品質を保証する方策として、より大量のデータを使ったり、学習の階層を増やしたりといった提案が行われがちです。

しかし、それでは本質的な解決にはならないと思います。高いパフォーマンスに加えて、どれだけ正しいアウトプットが行われているのかをきちんと説明する義務が、我々にはあるからです。その意味で、ブラックボックス問題の解決は、そう簡単なものではありません」

2つ目のバイアス問題は、学習させるデータそのものに偏りがある場合に起こる。例えば、「医師」といわれたときには男性を思い浮かべ、逆に「看護師」なら女性をイメージする人が少なくない。ここには人間の認知バイアスが潜む。本来なら医師や看護師などの職業区分と性別に関連性はないが、現実には、男女の偏りは存在する。収集したデータのほとんどが、男性医師と女性看護師だった場合、AIは白衣を着た女性医師の職業をどのように判断するか。おそらくは、「看護師」と自動的にラベリングしてしまうだろう。これが、バイアス問題である。

「画像認識システムが人の顔を動物と誤認し得る事例などで、慎重な議論があります。このようにバイアス問題は、倫理的な問題へと発展しかねません。こうした問題が生じるのは、そもそも社会にバイアスがあり、その結果として集められたデータにもバイアスがかかってしまうからです。根が深いために、解決するのは容易ではありません」

3つ目のセキュリティ問題も厄介だ。AIは、意外に騙されやすいという弱点がある。例えば、自動運転に使われる画像認識AIでは、赤地の円の中に白の線が真横に引かれたマークを認識すると、「進入禁止マーク」と判断しかねない。ところが、こうしたマークは、よく使われている汎用的なデザインでもある。仮に、そのようなマークを認識するたびに、自動運転のクルマが止まっていては衝突事故を起こしかねない。

「そもそも人間が見ても、似ているなと思うようなマークは、AIも誤認識しやすいのです。この際にも厄介なのが、なぜAIがそのように判断するのか、その判断に至った過程を人が理解できない点にあります。AIを意図的に誤認識させるような攻撃も考えられるので、セキュリティ面も考えなければなりません」

AIを搭載するシステムの「何に注目すべきか」をまとめたガイドライン

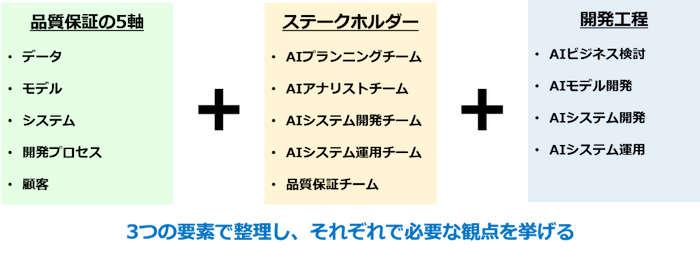

このように、現時点のAIはパーフェクトとはいえない。しかし現実問題として、AIの社会実装は始まっている。だからこそ、AIシステムの品質保証が問われているのであり、東芝は基本的な指針を「AI搭載システム品質保証ガイドライン」にまとめている。AIを開発し、システムに搭載する際、どこに着目して、何を注意するのか。品質面で考慮すべき点は何か。人がチェックすべき視点を網羅し、ガイドラインに則って開発が進められるようにしている。

「このガイドラインには、データの十分性や倫理性、法的な問題、顧客とのコミュニケーションのあり方、リスクに対する考え方などが網羅的に書かれています。ガイドラインのステークホルダーとして、AIシステムの開発者だけでなく、顧客と接する営業担当や、AIシステムの運用者などを含め、多様な視点からチェックポイントを含めています。

社会でAIが使われるほど、品質をどう保証しているのかが問われます。東芝のように社会インフラを担う企業では、その適切性がより重要になります。ガイドラインを完成したものと捉えず、社会や顧客と共に更新していきたいですね。ゆくゆくはAIの品質は担保されて当たり前になり、AIがさらに活用され社会を支えるようになると思いますし、そうしていきたいです」

久連石氏らは、上記ガイドラインに加えてAIを開発する際のプロセスも具体的に整備している。また、それを支援するためにAIの品質を評価する技術や、可視化する技術も開発しているという。これらについて、東芝独自の取り組みとして後編で詳しく紹介する。

東芝のAI搭載システム品質保証ガイドラインの考え

関連サイト

※ 関連サイトには、(株)東芝以外の企業・団体が運営するウェブサイトへのリンクが含まれています。

https://www.global.toshiba/content/dam/toshiba/jp/technology/corporate/review/2022/02/1-3.pdf

本件の参照先:https://www.global.toshiba/jp/company/digitalsolution/news/2022/0819.html